Cuando pensamos en IA y ciberseguridad, suele venirnos a la mente la imagen de ingenieros de seguridad utilizando la IA como un aliado en su lucha contra el cibercrimen. Siendo totalmente cierta esa imagen, solo representa una pequeña parte de la foto completa. Hoy el uso de la IA se ha democratizado hasta el extremo de que los ciberatacantes la usan rutinariamente para optimizar y escalar sus ataques. Según el informe de amenazas de ENISA 2024, más del 50 % de los actores maliciosos ya integran herramientas de IA en sus campañas. Por otro lado, el despliegue masivo de modelos de IA en sectores críticos solo podía atraer la atención de los actores maliciosos: ciberterrorismo, cibercrimen, ciberguerra, etc.

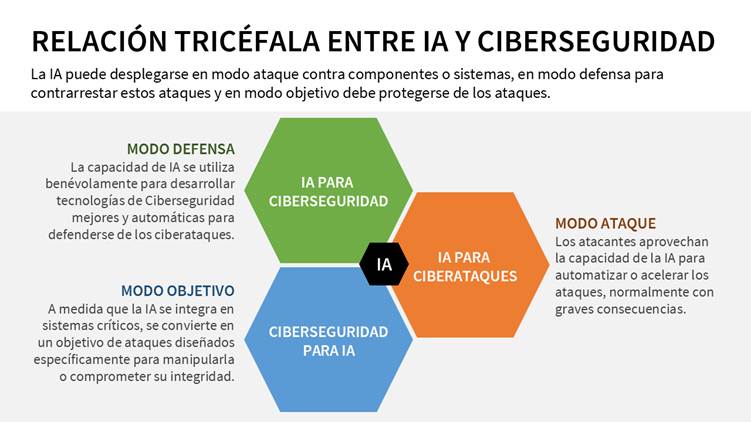

Este auge del uso de las herramientas de IA, sin precedentes en la historia de la tecnología, está generado una compleja dinámica que bien puede entenderse como una relación tricéfala:

- La IA como herramienta de ciberdefensa

- La IA como vector ofensivo en manos de atacantes

- La IA como objetivo vulnerable que requiere protección.

Esta triple perspectiva (IA para ciberseguridad, IA para ciberataques y ciberseguridad para IA) refleja el nuevo campo de batalla digital en el que combaten ciberatacantes y ciberdefensores.

IA para Ciberseguridad: el modo defensa

En su modalidad defensiva, la IA se consolida como el detonante de la automatización de sistemas de detección, respuesta y prevención de amenazas. Los algoritmos de Machine Learning (ML) permiten identificar patrones anómalos en el tráfico de red, detectar intrusiones con mayor precisión que las firmas tradicionales y generar respuestas adaptativas en tiempo real. Tecnologías como el threat hunting basado en IA, el User and Entity Behavior Analytics (UEBA) o los Sistemas de Detección de Intrusos (IDS) inteligentes son ya componentes comunes en centros de operaciones de seguridad (SOC).

En los últimos avances destaca el uso de modelos fundacionales como transformers adaptados a ciberseguridad, capaces de analizar millones de eventos por segundo y correlacionar incidentes complejos. Asimismo, el uso de IA generativa para automatizar informes de incidentes y asesorar en la toma de decisiones estratégicas está marcando una diferencia operativa sustancial.

IA para Ciberataques: el modo ataque

La misma capacidad que convierte a la IA en una aliada para la ciberdefensa, hace de ella un arma temible en manos de los ciberatacantes. En modo ataque, la IA se emplea para automatizar campañas de phishing altamente personalizadas, evadir sistemas de detección, generar malware polimórfico y realizar reconocimiento automatizado en fases iniciales de intrusión. Un caso paradigmático es el uso de modelos generativos de lenguaje para construir correos de ingeniería social con un nivel de persuasión y contextualización que supera al de los atacantes humanos.

El uso de deepfakes se ha convertido en una amenaza clave en las relaciones personales, donde se crean videos falsos para difamar o manipular a individuos, afectando su vida personal y profesional. En el ámbito político, podríamos ver democracias debilitadas por líderes que niegan sus crímenes bajo la excusa de “es un deepfake”. En la esfera de lo personal, las relaciones humanas podrían enfrentar una crisis de confianza sin precedentes, donde la sospecha permanente envenene la comunicación y el vínculo interpersonal. De hecho, se ha creado una disciplina de ciberseguridad para combatirlos: disinformation security.

Ciberseguridad para la IA: el modo objetivo

Finalmente, a medida que los sistemas de IA se integran en infraestructuras críticas —desde sanidad hasta energía o defensa—, se convierten en objetivos de ataque por derecho propio. Asegurar su integridad, disponibilidad y confidencialidad implica enfrentar el auge de los llamados ataques adversariales: técnicas que manipulan los datos de entrada de un sistema de IA para inducir errores sistemáticos, como la inyección de prompts, el robo de modelos (model stealing), la inferencia de datos sensibles a partir de salidas del modelo y el envenenamiento de datos de conjuntos de entrenamiento. Estos ataques permiten, por ejemplo, que un sistema de visión artificial interprete señales de tráfico erróneamente, con consecuencias potencialmente catastróficas en vehículos autónomos.

La necesidad de una ciberseguridad específica para IA ha dado lugar al campo emergente del AI Red Teaming, que evalúa la resiliencia de los modelos ante ataques sofisticados, y al desarrollo de marcos normativos, como el propuesto por el NIST, AI Risk Management Framework (AI RMF), o por la Unión Europea, con su AI Act, que establecen principios de robustez, transparencia y auditabilidad, sin olvidar la reciente norma ISO 42001 Information technology — Artificial intelligence — Management system, para que las organizaciones desarrollen y utilicen inteligencia artificial de forma responsable, ética y conforme a la normativa vigente.

Conclusión

La relación tricéfala entre IA y ciberseguridad impone una nueva agenda de investigación, regulación y capacitación profesional. Comprender y anticipar la evolución de estas tres puntas de lanza (defensa, ataque y objetivo) resultará esencial para garantizar un ecosistema digital seguro y resiliente. Solo una estrategia conjunta entre investigadores, profesionales y reguladores podrá anticiparse al avance de amenazas cada vez más autónomas y camaleónicas. Es momento de pensar la ciberseguridad no solo como tecnología, sino como cultura y responsabilidad compartida.

Conoce nuestro Máster Profesional en Dirección de Ciberseguridad, Hacking Ético y Seguridad Ofensiva.